# 调度引擎管理

调度引擎是一个分布式易扩展的作业流任务调度系统。调度引擎以 DAG(Directed Acyclic Graph,DAG)流式方式组装任务,可以及时监控任务的执行状态,支持重试、指定节点恢复失败、暂停、恢复、终止任务等操作。

调度引擎管理涉及的功能包括:

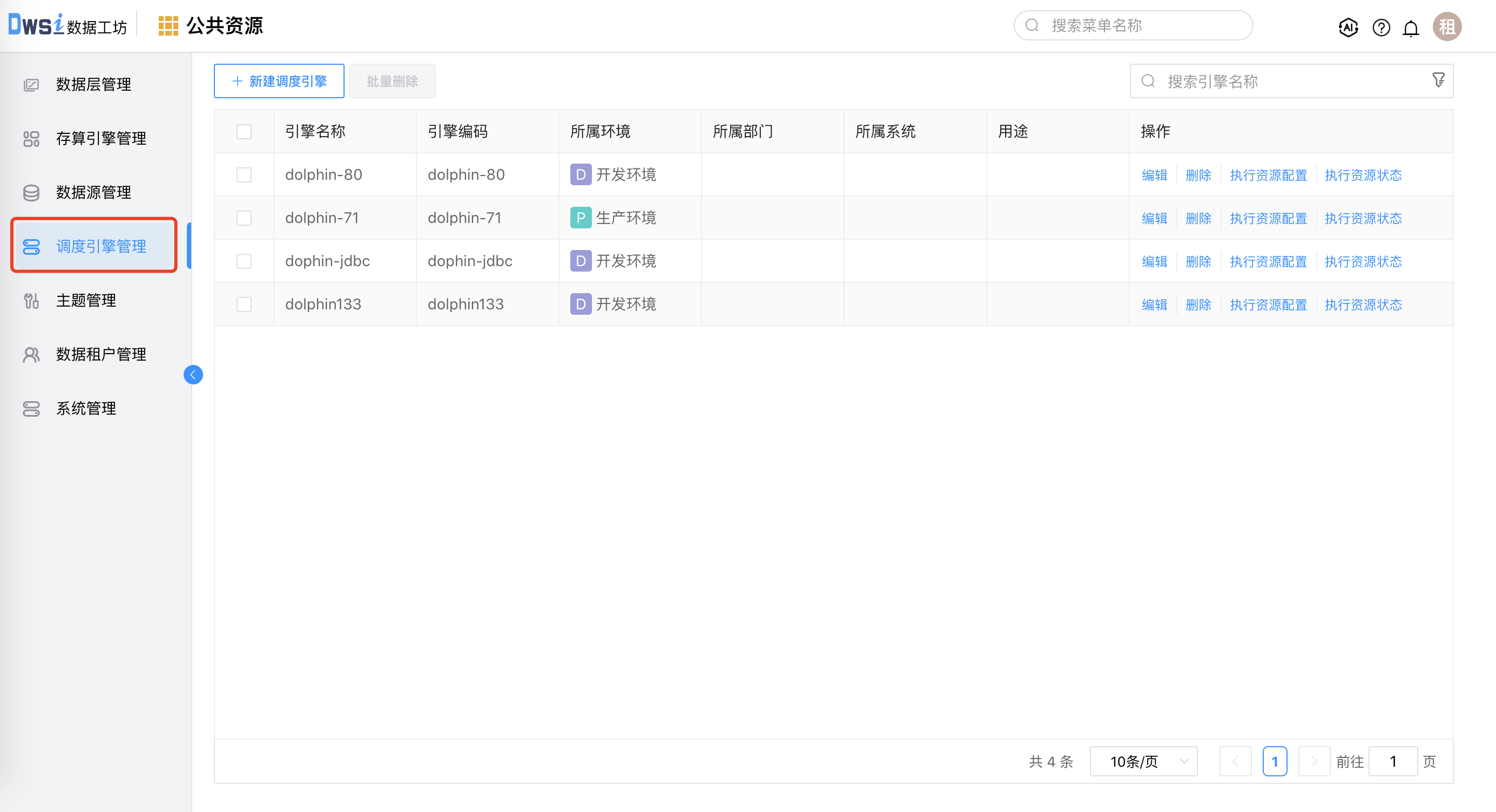

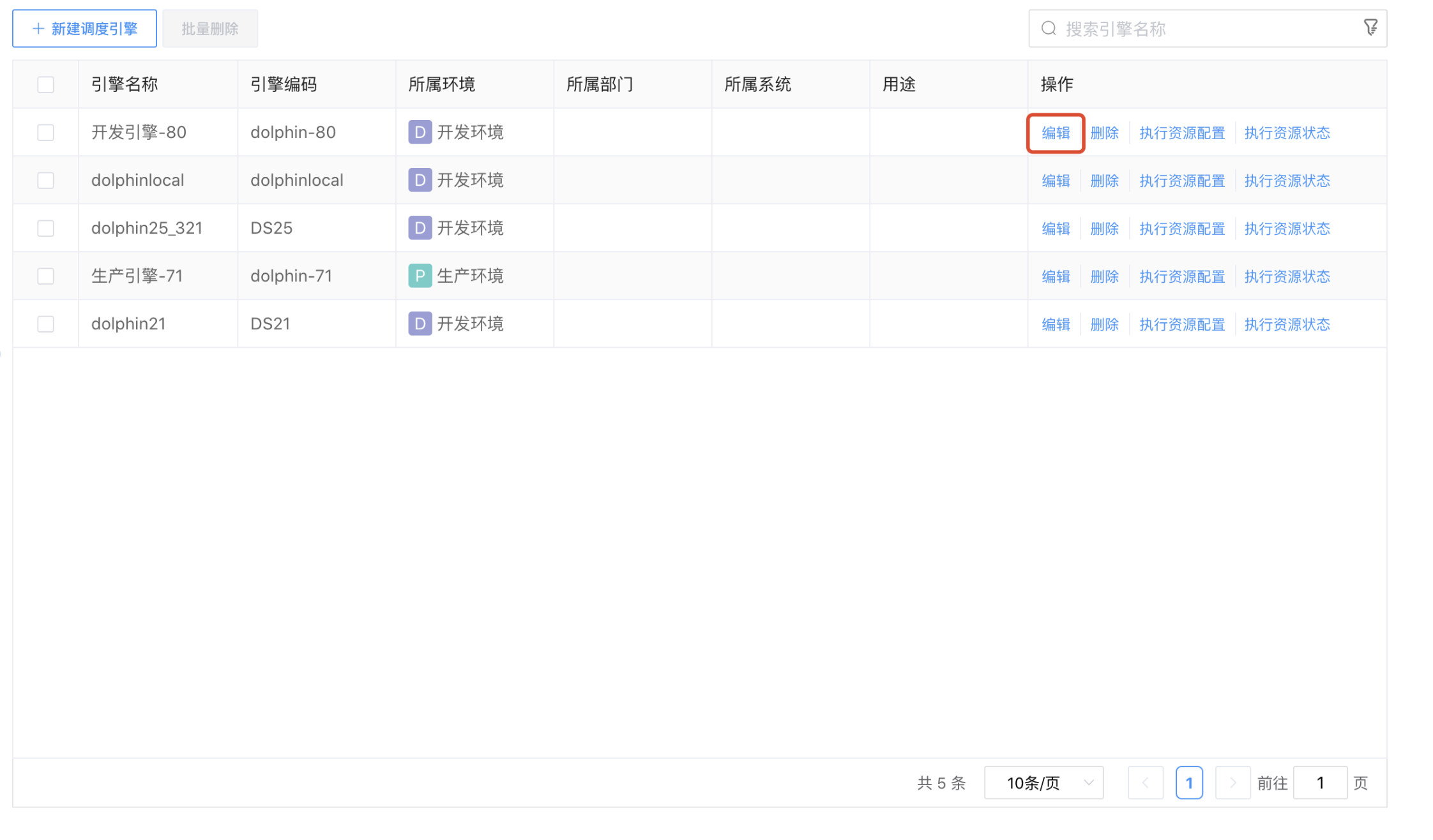

点击上方菜单栏“调度引擎管理”,进入作业调度管理界面。

# 新增调度引擎

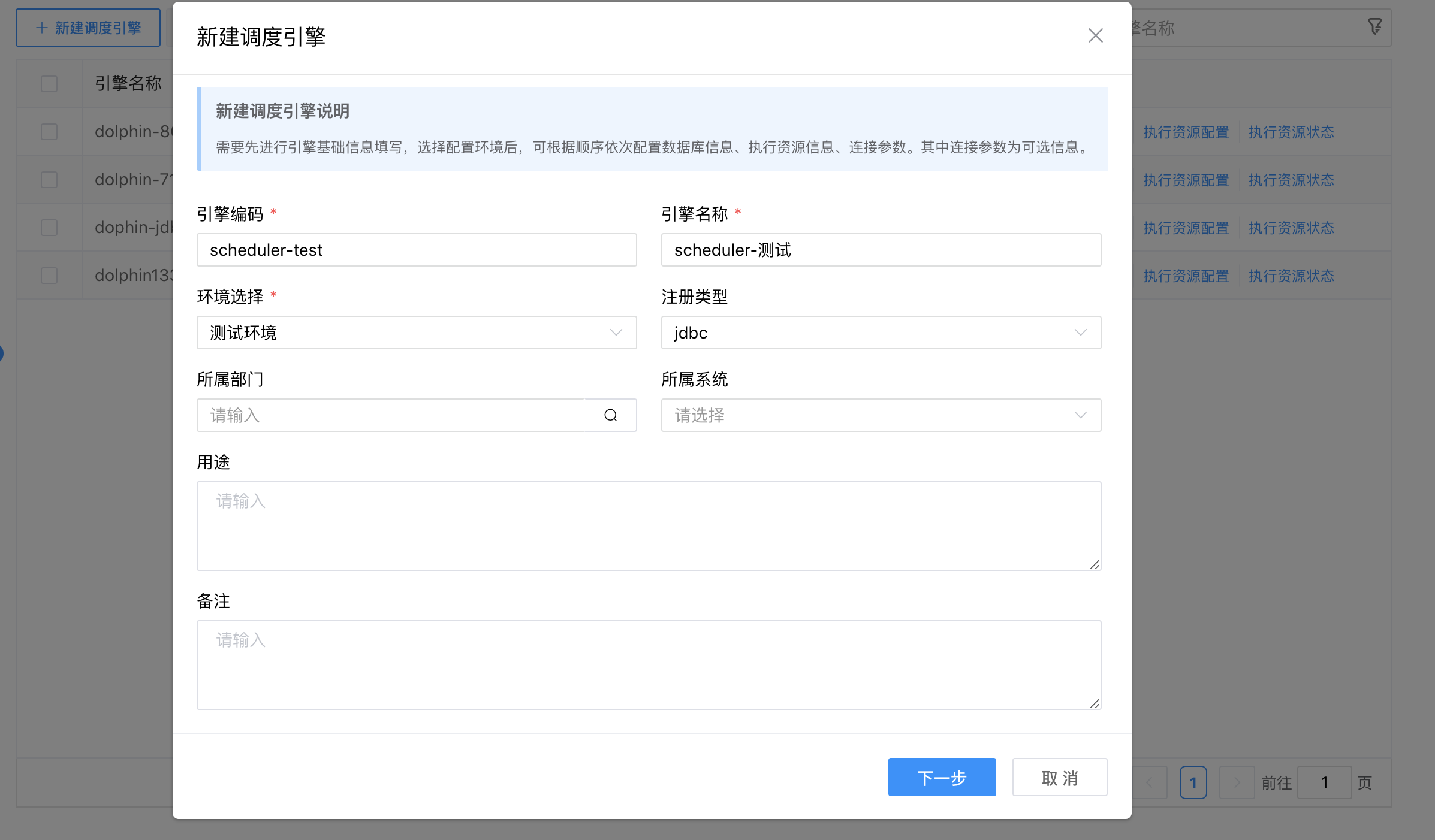

点击【+新建调度引擎】按钮,弹出"新建调度引擎"界面。按照向导页面要求录入调度引擎的参数配置信息。

1、引擎编码必须和配置文件中的 org.quartz.scheduler.instanceName: scheduler-test 保持一致(比如:scheduler-test)。用户可以自行修改配置文件的 instanceName ,然后再创建调度引擎。

2、如果 instanceName 不一致,会造成定时调度任务不执行的问题。

配置文件路径:/apache-dolphinscheduler-7.1.0-bin/master-server/conf/application.yaml

具体如下:

(略)

properties:

org.quartz.threadPool.threadPriority: 5

org.quartz.jobStore.isClustered: true

org.quartz.jobStore.class: org.springframework.scheduling.quartz.LocalDataSourceJobStore

org.quartz.scheduler.instanceId: AUTO

org.quartz.jobStore.tablePrefix: QRTZ_

org.quartz.jobStore.acquireTriggersWithinLock: true

org.quartz.scheduler.instanceName: scheduler-test

org.quartz.threadPool.class: org.quartz.simpl.SimpleThreadPool

org.quartz.jobStore.useProperties: false

org.quartz.threadPool.makeThreadsDaemons: true

org.quartz.threadPool.threadCount: 25

org.quartz.jobStore.misfireThreshold: 60000

org.quartz.scheduler.batchTriggerAcquisitionMaxCount: 1

org.quartz.scheduler.makeSchedulerThreadDaemon: true

org.quartz.jobStore.driverDelegateClass: org.quartz.impl.jdbcjobstore.PostgreSQLDelegate

org.quartz.jobStore.clusterCheckinInterval: 5000

(略)

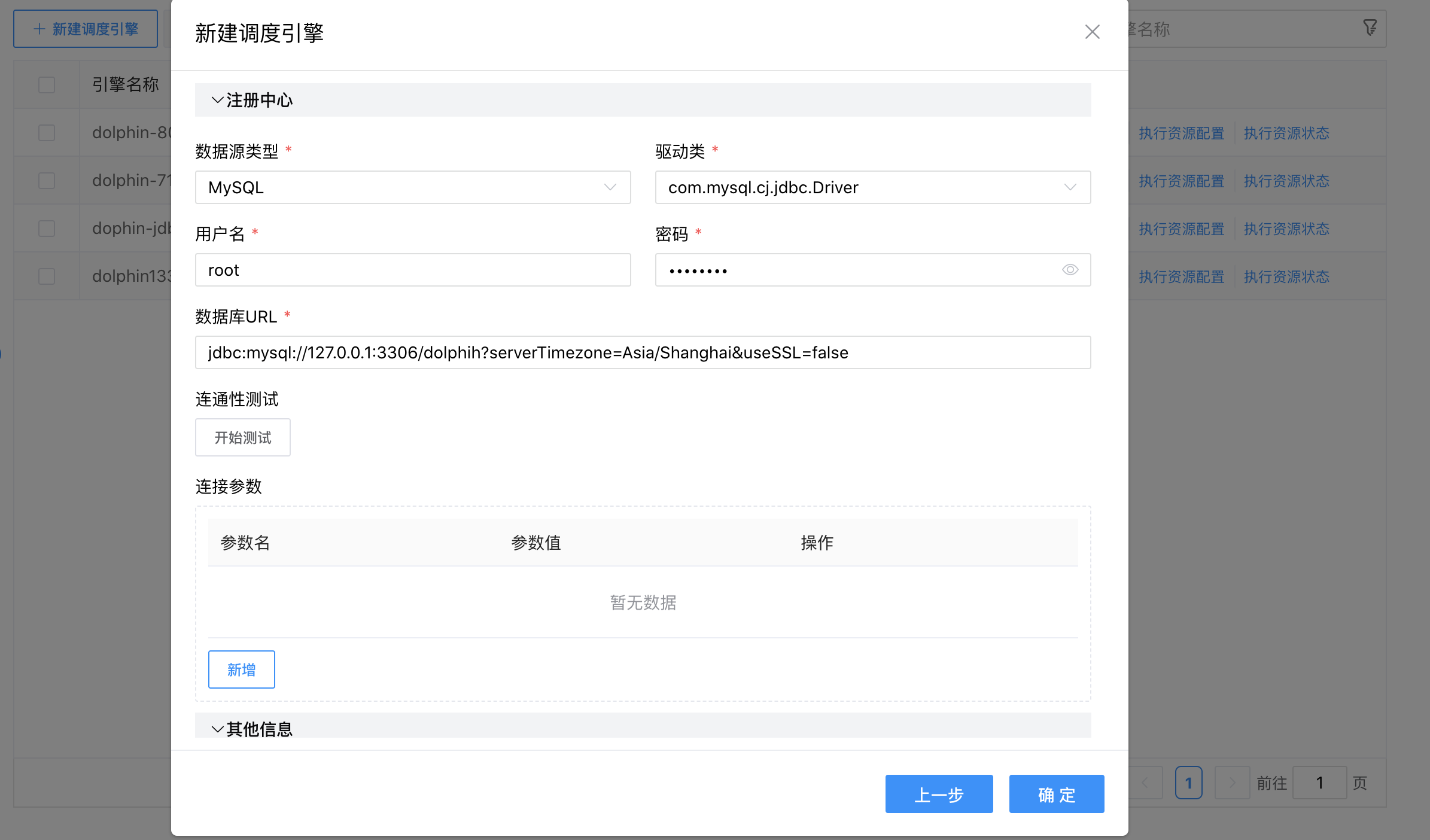

点击【下一步】按钮,按照向导页面要求继续录入调度引擎参数配置。

点击【确定】按钮,完成新建调度引擎的操作。

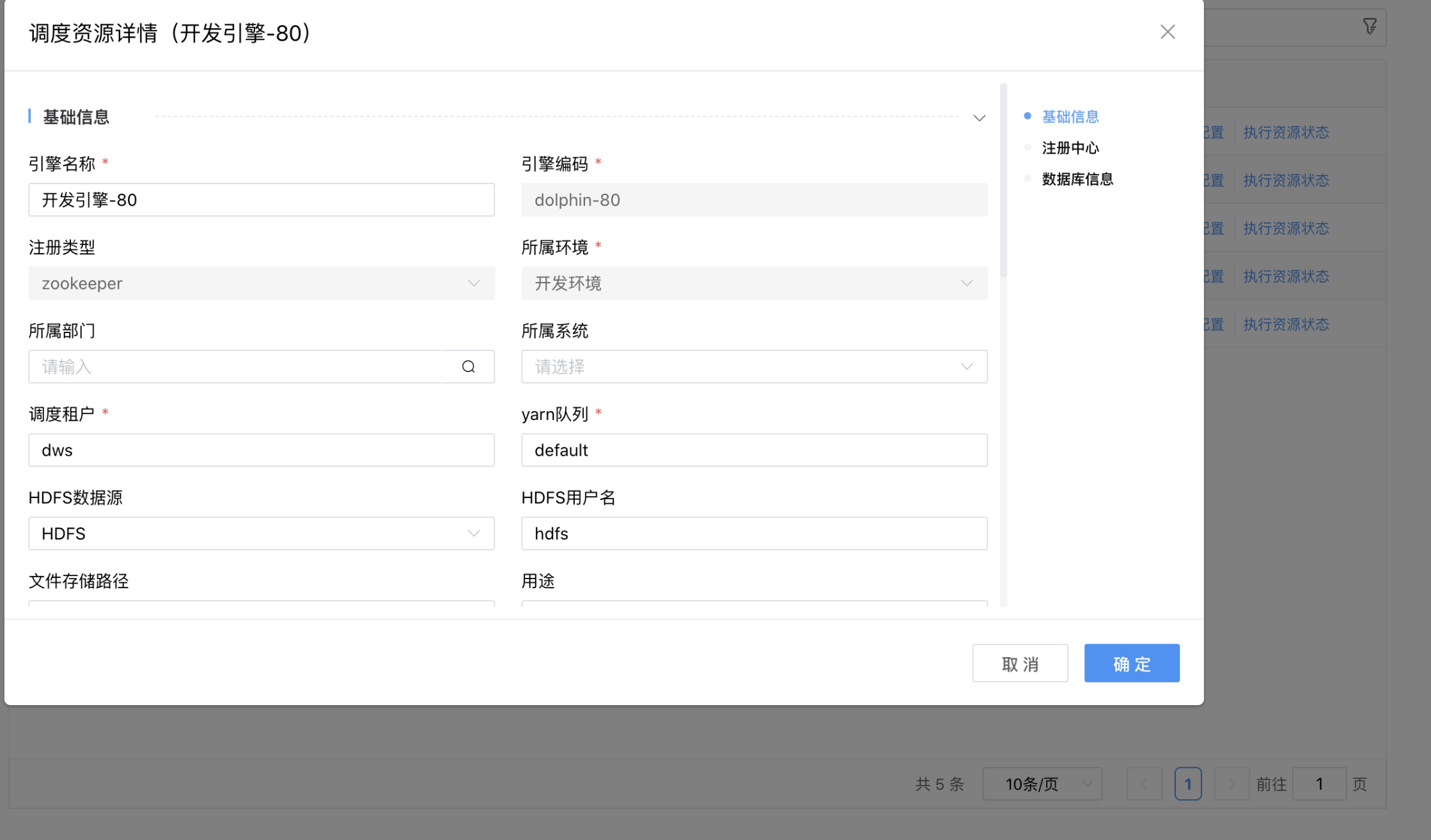

参数说明:

| 参数 | 说明 |

|---|---|

| 引擎名称 | 当前创建的调度引擎名称,由用户自定义且不可为空。命名可包含汉子、字母、数字、下划线。 |

| 引擎编码 | 当前创建的调度引擎编码,由用户自定义且不可为空。命名可包含字母、数字、下划线。 |

| 注册类型 | 目前支持 jdbc 和 zookeeper 两种方式。介质默认支持 jdbc 注册方式。 |

| 环境选择 | 当前创建的调度引擎所属的环境,从下拉选项选择(数据字典)且不可为空。 |

| 所属部门 | 当前创建的调度引擎所属部门,从机构选项进行选择。 |

| 所属系统 | 当前创建的调度引擎所属系统,从下拉选项选择(数据字典)。 |

| 用途 | 当前创建的调度引擎的用户说明。 |

| 备注 | 当前创建的调度引擎的备注信息,用于记录用户自定义内容。 |

| 注册中心 | 当注册类型选择“jdbc”时,需要配置该 jdbc 的数据源类型、驱动类、用户名、密码、数据库URL等参数。 当注册类型选择“zookeeper”时,需要配置当前创建的调度引擎的 zookeeper 注册地址和 namespace 。 namespace 即部署 DolphinScheduler 时在 bin/env/install_env.sh 中配置的 zkRoot=${zkRoot:-"/dws"}。 |

| 连接参数 | 当前创建的调度引擎的连接参数。 |

| 调度租户 | 当前创建的调度引擎的调度租户信息。是 DWS安装必读 时创建的免密用户,即在 bin/env/install_env.sh 中配置的 deployUser=${deployUser:-"dws"}。 |

| yarn队列 | 当前创建的调度引擎的 yarn 队列名称。 |

| HDFS数据源 | 当前创建的调度引擎的 HDFS 数据源(只读)。 HDFS数据源、HDFS用户名、文件存储路径都是从配置文件中读取,如若修改,请参见:DolphinScheduler安装指南4.对接分布式或远端对象存储。 |

| HDFS用户名 | 当前创建的调度引擎的 HDFS 用户名(只读)。 |

| 文件存储路径 | 当前创建的调度引擎的 HDFS 文件存储路径(只读)。 |

# 修改调度引擎

点击存算引擎列表右侧的【编辑】按钮,弹出"调度资源详情"弹窗,用户可以根据需求进行参数的修改。

点击【确定】按钮,完成参数的修改、保存。

点击【取消】按钮,取消本次修改操作。

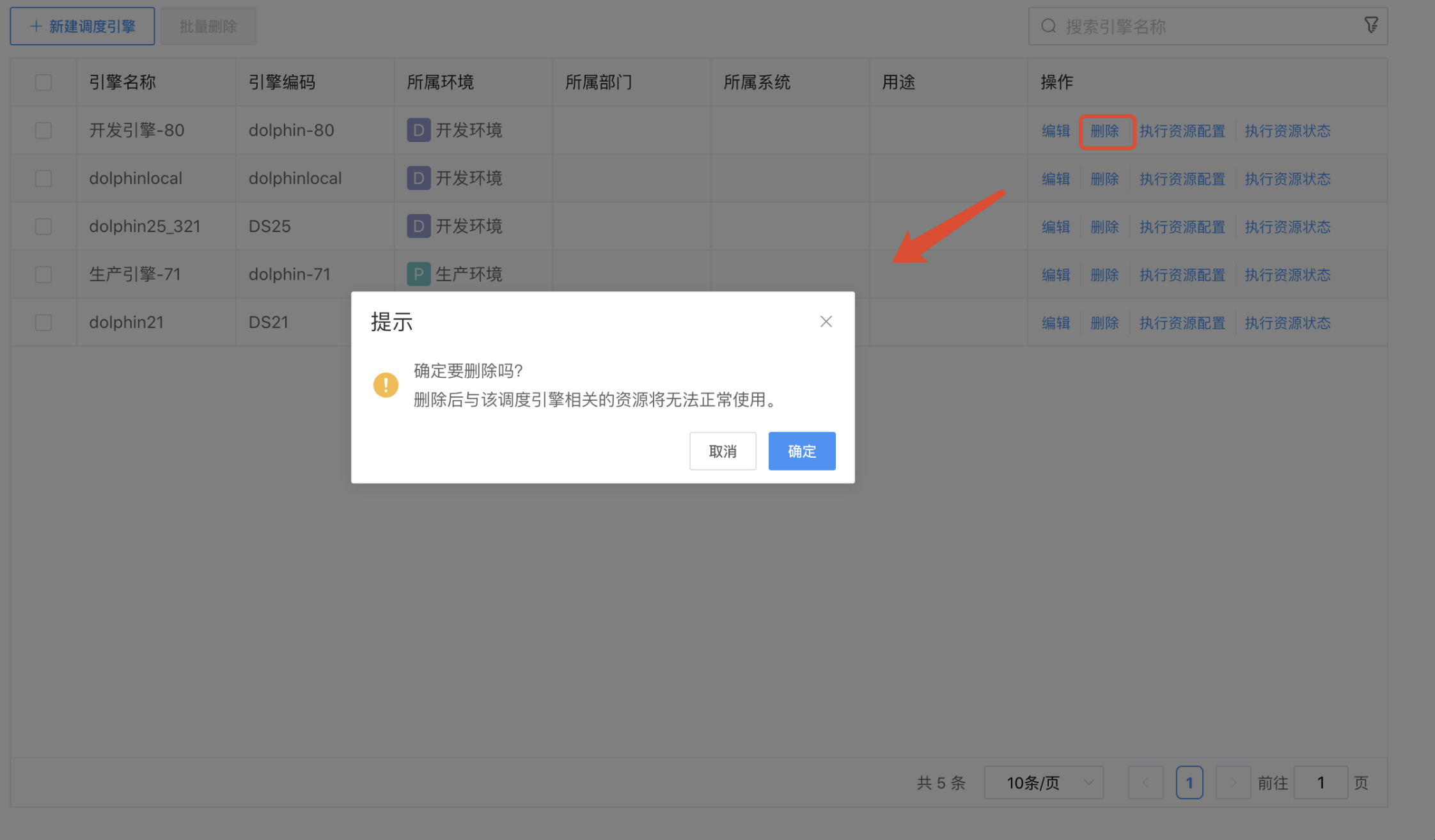

# 删除调度引擎

点击调度引擎列表后边的【删除】按钮,弹出"删除确认"信息。按照要求解绑后才能继续删除操作。

点击弹框的【确认】按钮,完成删除操作。

点击弹框的【取消】按钮,取消本次删除操作。

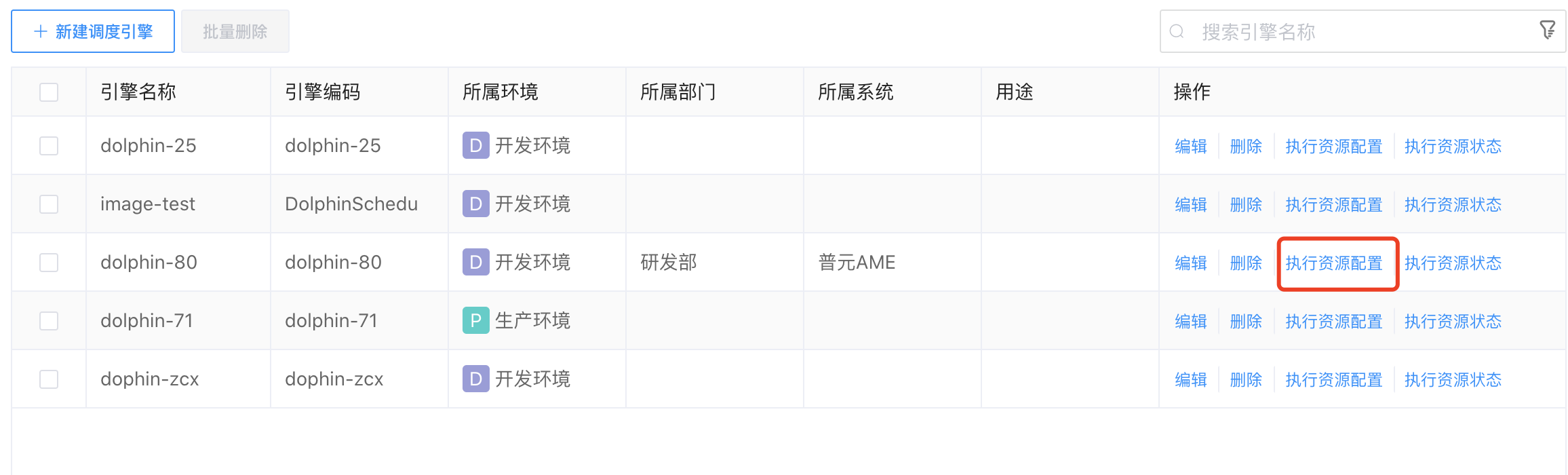

# 执行资源配置

点击调度引擎列表后边的【执行资源配置】按钮,弹出"执行资源配置"弹窗。

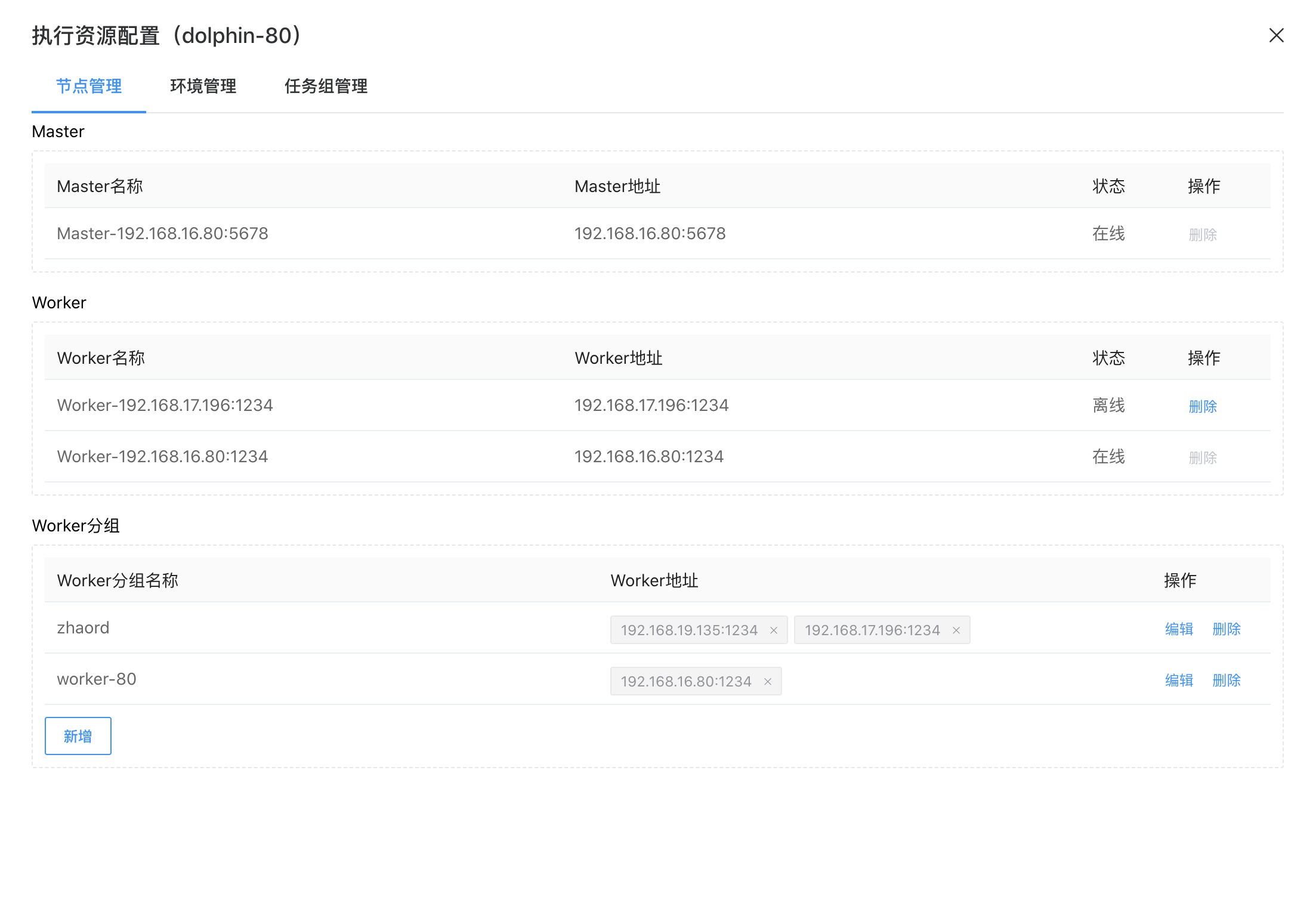

# 节点管理

选择“节点管理”,可以管理调度引擎的 Worker 节点。

点击底部的【新增】按钮,可以添加执行资源的 Worker 分组。用户可以将选择不同 Worker 节点放在同一个分组中。

1、Master、Worker 下列表显示的节点会自动发现并显示,不允许删除。

2、Worker分组名称具有唯一性,不允许重名。

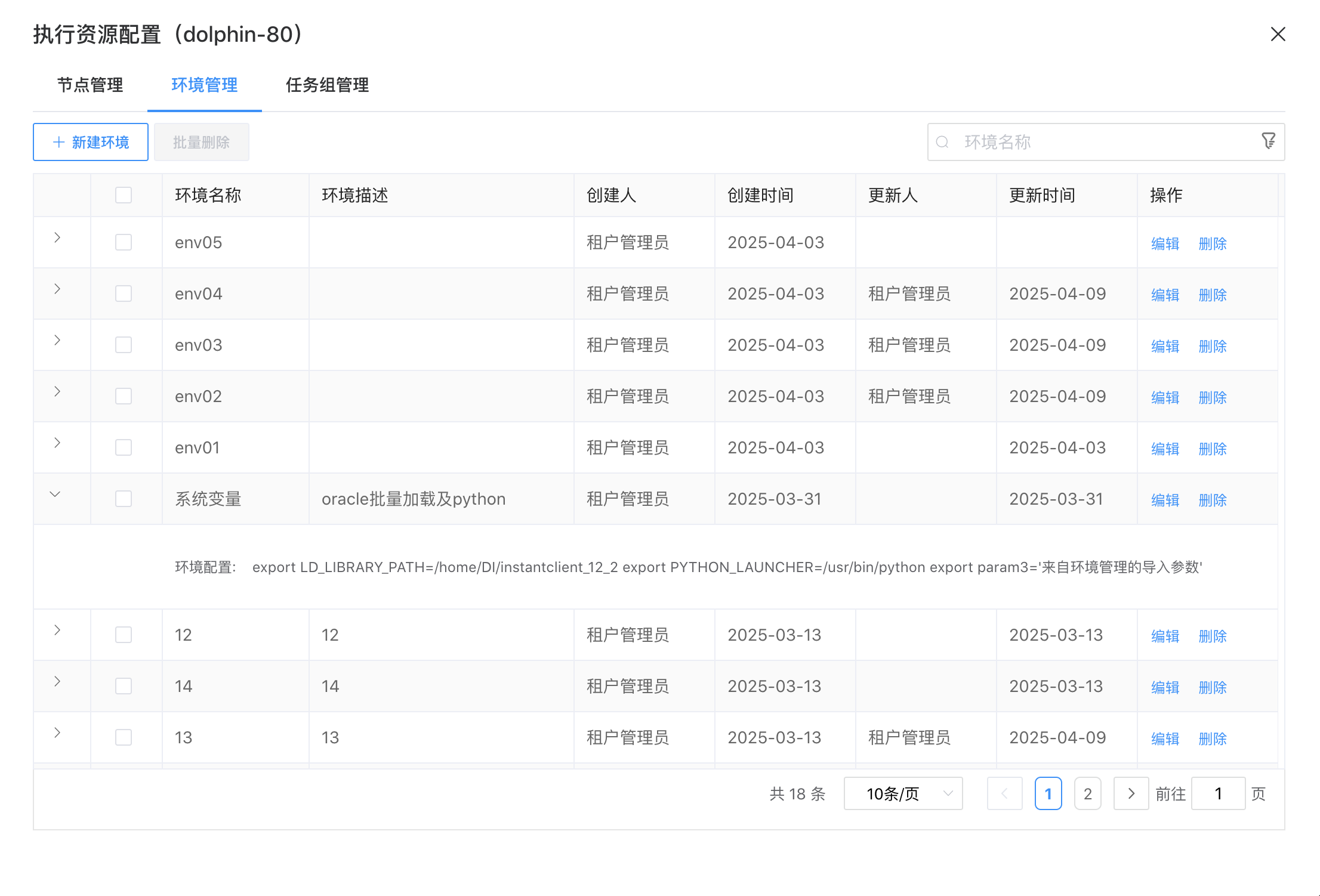

# 环境管理

环境管理用于管理一个 Worker 的多个环境。在任务执行时,将任务分配给指定 Worker 分组,根据 Worker 分组选择对应的环境,最终由该组中的 Worker 节点执行环境来执行任务。

比如:Worker1 配置了两个 DI 环境 DI1、DI2,在 IDE 的通用配置中,作业1选择环境“DI1”,作业2选择环境“DI2”,则在具体执行时作业1、作业2分别在环境 DI1、DI2 执行。

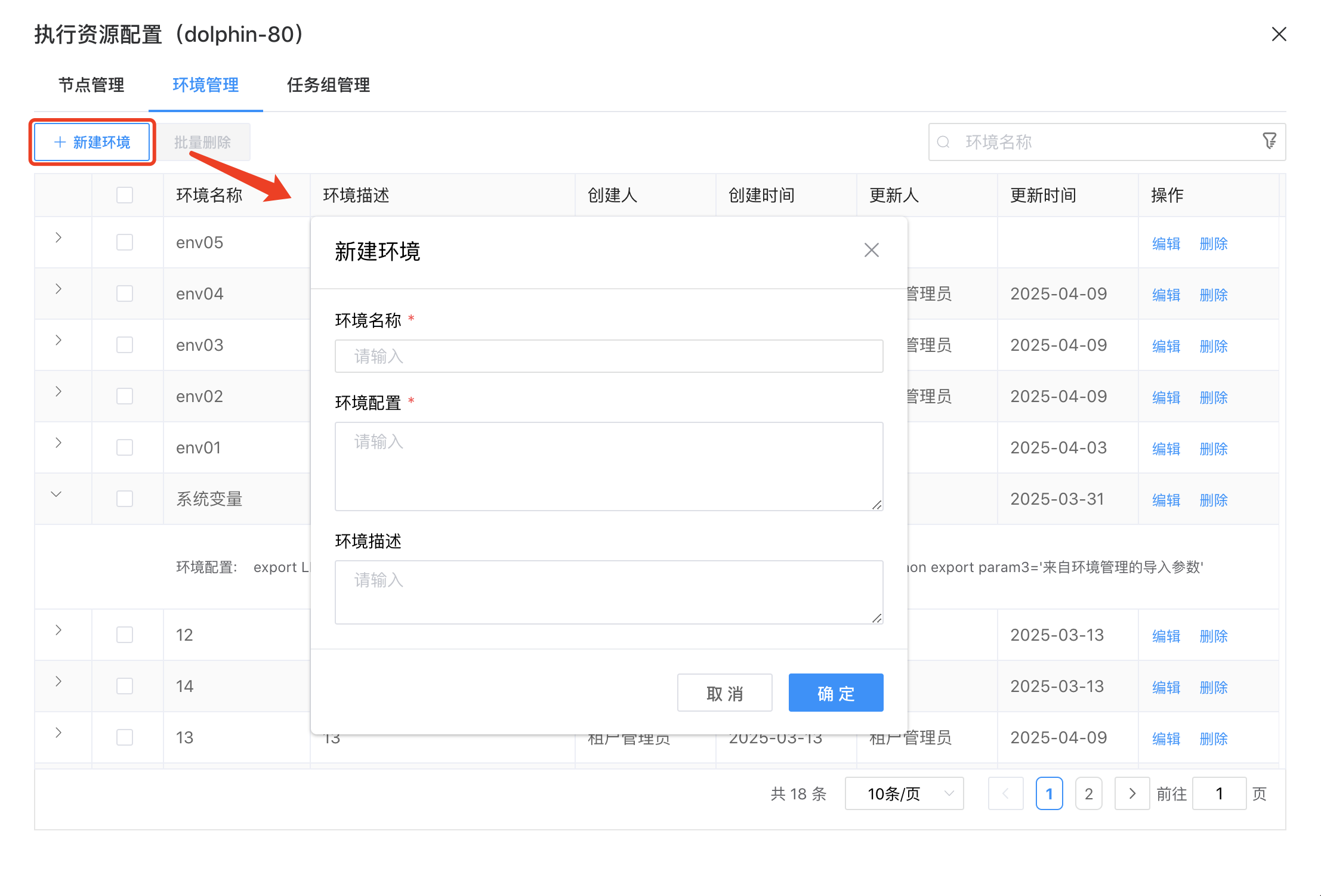

选择“环境管理”,进入环境管理界面。

点击【新建环境】按钮,填入环境名称、环境配置、环境描述,即可新建 Worker 环境。

点击【编辑】,可以修改环境信息。

点击【删除】,可以删除已经配置好的环境。

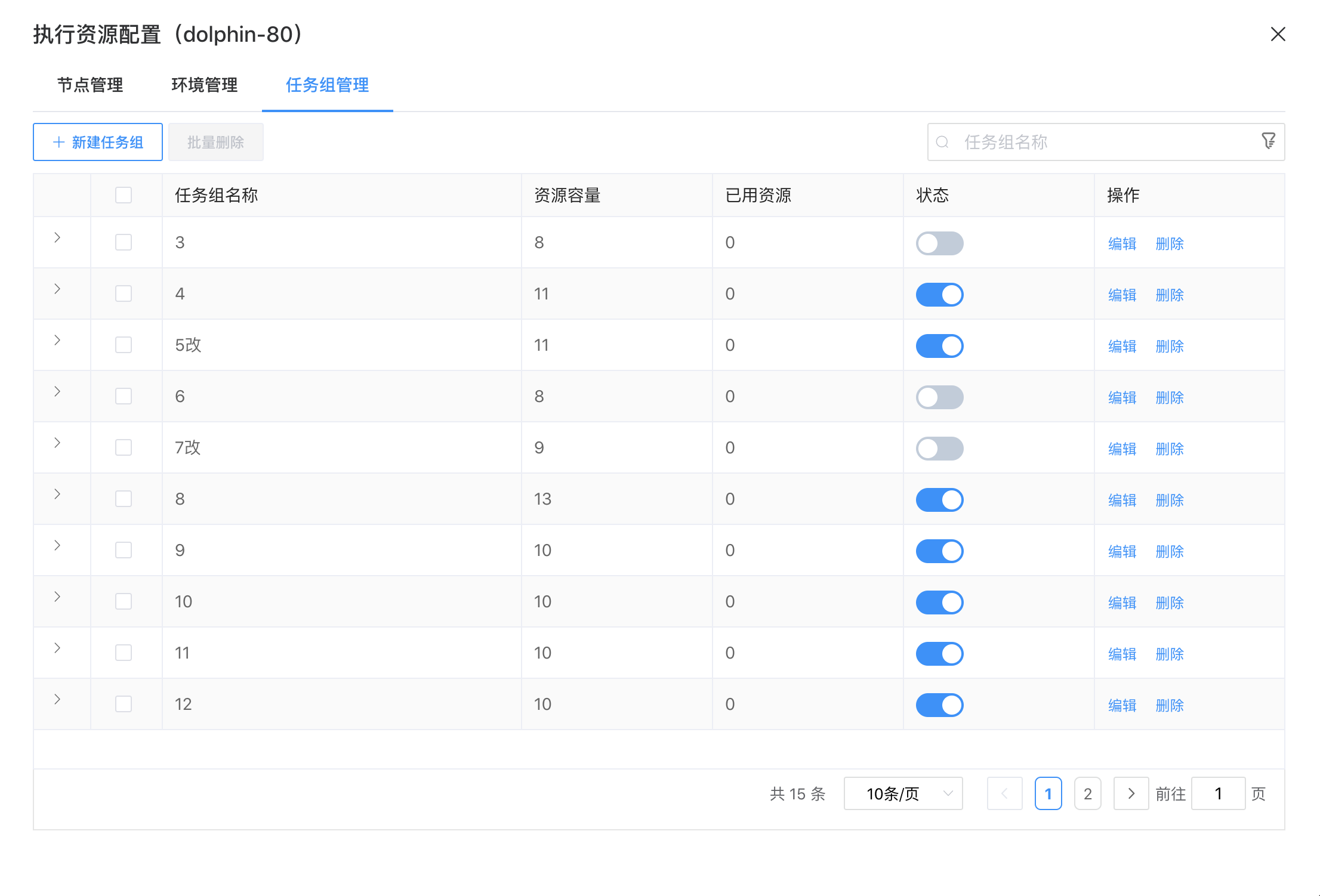

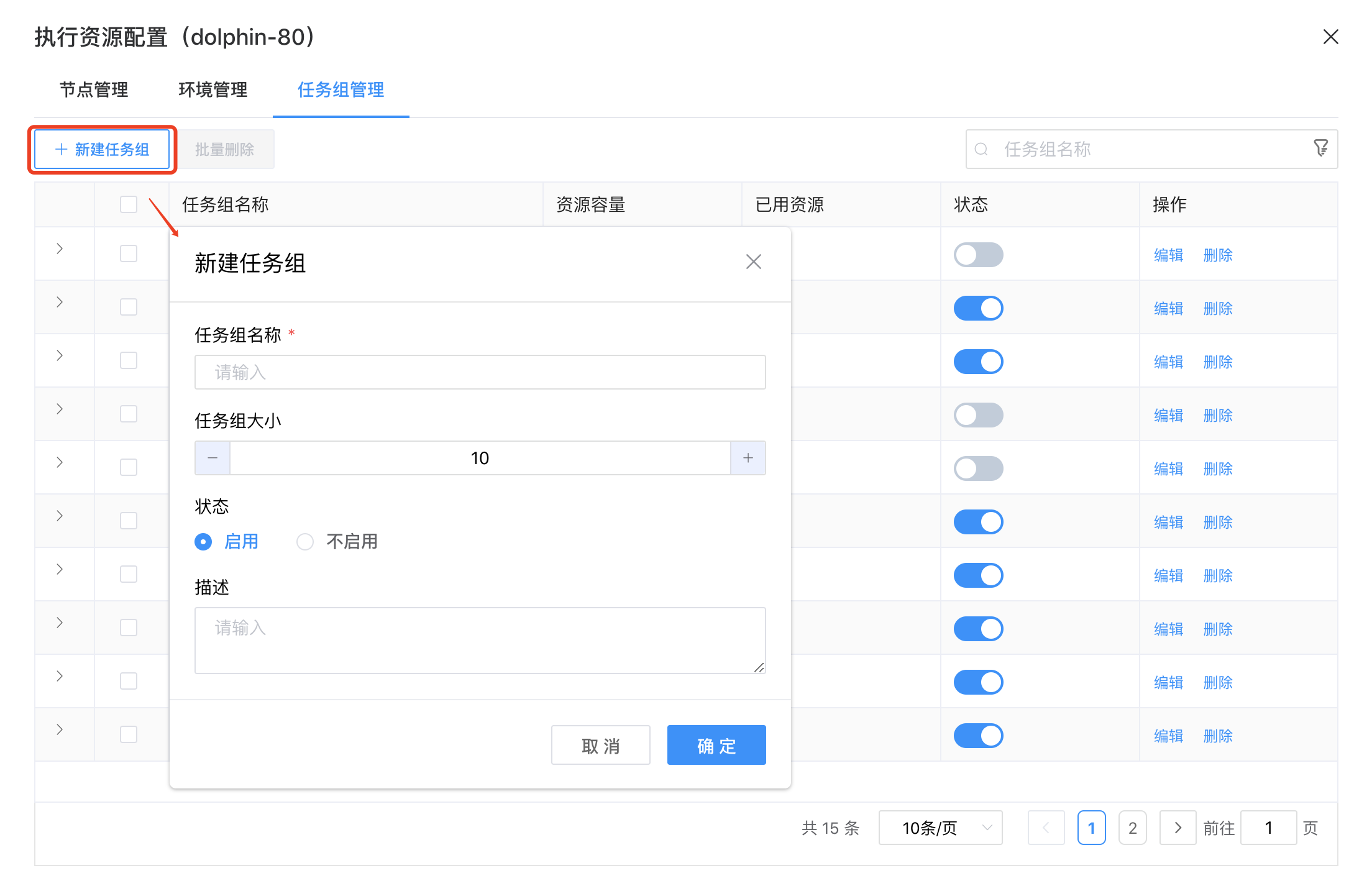

# 任务组管理

任务组用于控制任务实例并发。针对不同项目,可以配置对应的任务组,并配置任务在任务组内运行的优先级。

选择“任务组管理”,进入任务组管理界面。

点击【新建任务组】按钮,填入任务组名称、任务组大小、启用/不启用、描述,即可新建任务组。

点击【编辑】,可以修改任务组。

点击【删除】,可以删除已经创建的任务组。

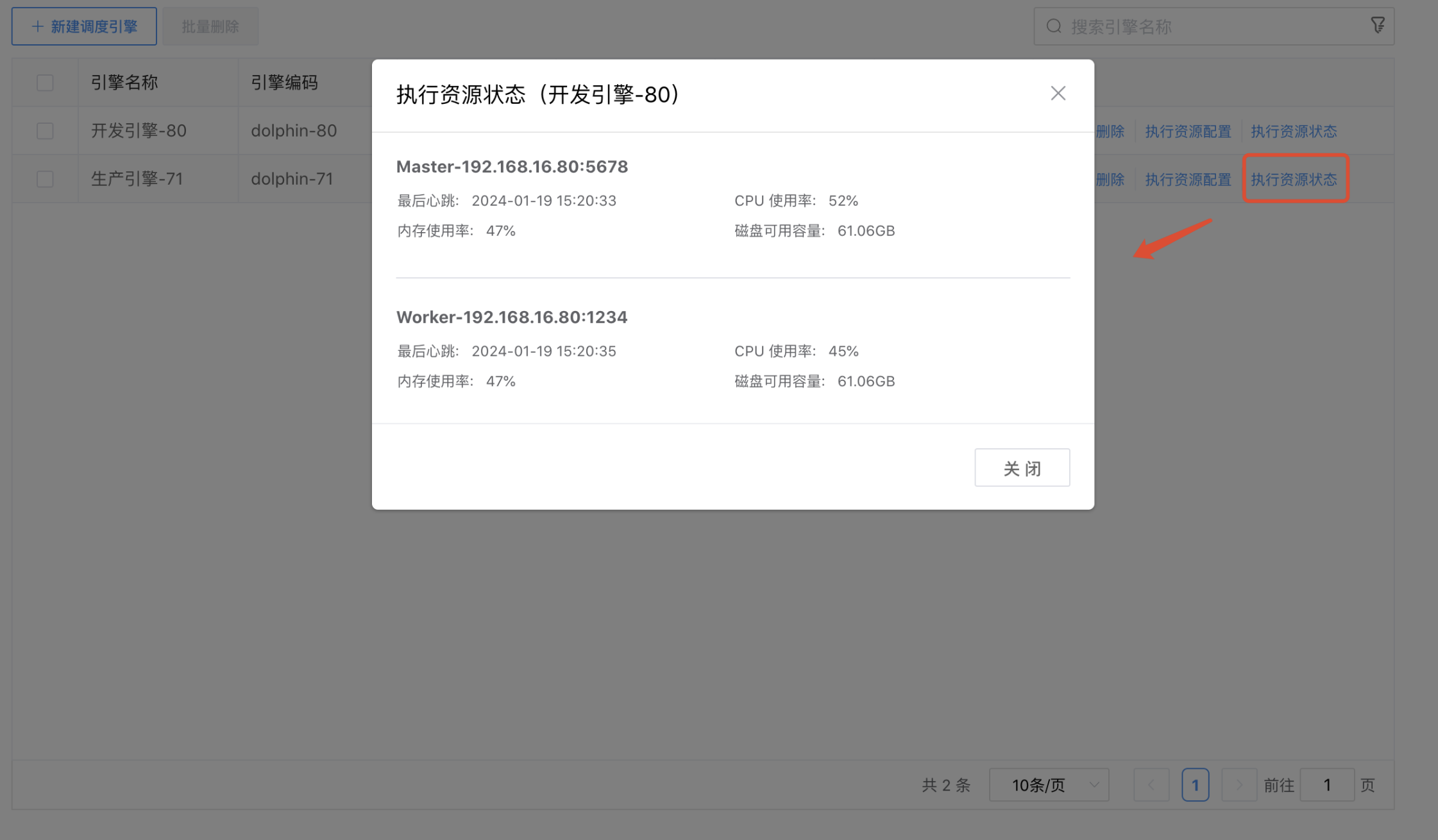

# 执行资源状态

点击调度引擎列表后边的【执行资源状态】按钮,弹出"执行资源状态"弹窗。可以查看对应调度引擎的 Master 和 Worker 的资源状态,包括:Master 和 Worker 的节点地址、心跳、CPU 使用率、内存使用率、磁盘可用容量。

# 搜索

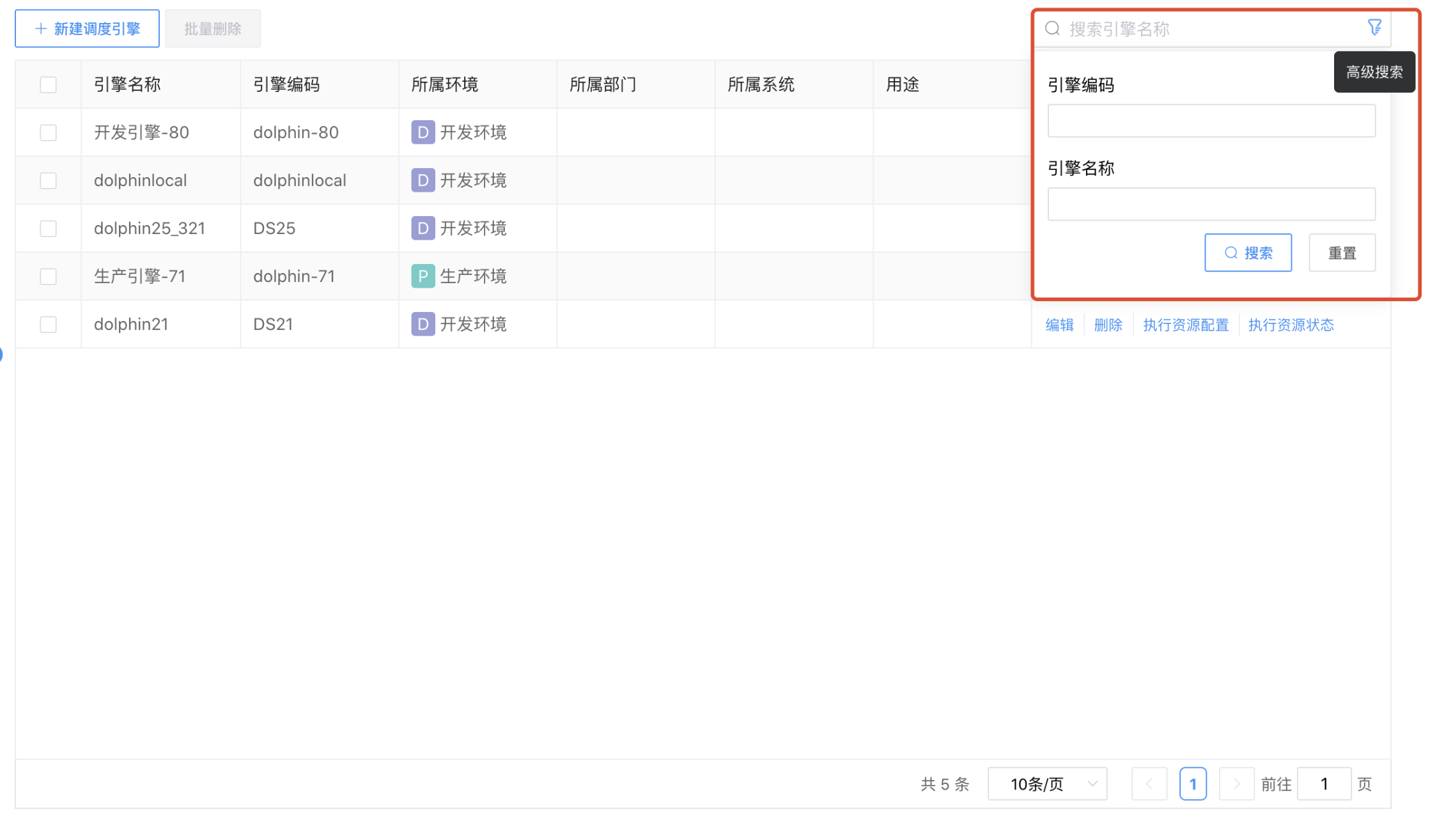

点击调度引擎列表右上方的【高级搜索】按钮,输入搜索条件"引擎编码"或者"引擎名称",点击【搜索】按钮,可以按照条件完成模糊查询,点击【重置】按钮,可以清空搜索条件。